Лаборатория исследований искусственного интеллекта T-Bank AI Research представила созданную ее специалистами новую архитектуру быстрых языковых моделей ReBased, которая позволяет эффективнее решать специализированные задачи в обработке естественного языка.

Нейросеть сокращает расходы на вычислительные мощности при использовании ИИ практически без потерь в качестве. В перспективе это может расширить коммерческое использование языковых моделей, которое сейчас ограничено высокой ресурсозатратностью. Кроме того, снижение потребления энергии в области вычислений, особенно в больших ЦОД позволит снизить выбросы парниковых газов.

Результаты исследования были представлены в августе 2024 г. на международной конференции по компьютерной лингвистике (ACL) в Бангкоке. Научную работу цитировали исследователи эффективности ИИ, представляющие Принстонский университет и Университет Карнеги – Меллона (их наработки используют почти все языковые модели в мире).

Как поясняют в T-Bank AI Research, самые распространенные языковые модели основаны на архитектуре Transformer, представленной в 2017 г. исследователями из Google. Они хорошо зарекомендовали себя при решении практических задач, но для них требуется очень много ресурсов, количество которых растут квадратично с удлинением текста. Для широкого практического применения необходимы менее ресурсозатратные архитектуры.

Наиболее успешные конкуренты трансформеров – последние SSM-модели (State Space Model, модели пространства состояний) Mamba, но они уступают по способности контекстного обучения, которое позволяет ИИ-агентам адаптироваться к новым задачам без повторного обучения.

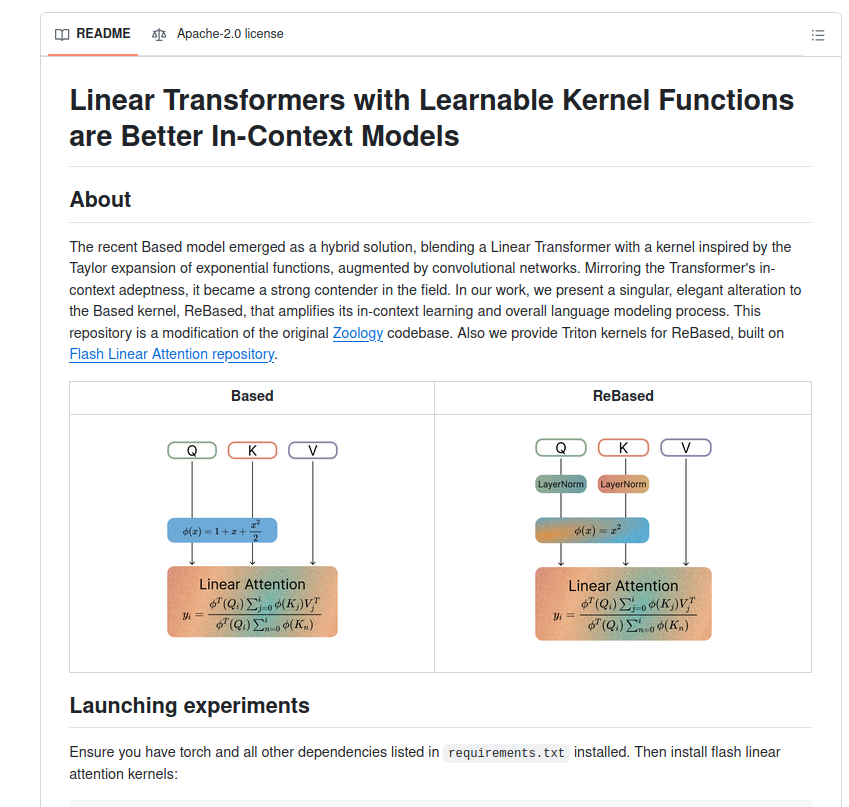

В представленной учеными Стэнфорда в декабре 2023 г. модели Based, которая значительно улучшила способности контекстного обучения, исследователи из T-Bank AI Research обнаружили неэффективное использование ресурсов из-за неоптимальной структуры нейросети. Проведя анализ архитектуры Based, они оптимизировали механизм извлечения информации из текста, добавив новые обучаемые параметры, которые отвечают за оптимальный поиск взаимосвязей между частями текста. Это позволяет улучшить процесс его обработки и получать более точные ответы. Ученые также упростили алгоритм выделения текстовой информации, что увеличило производительность, повысило качество работы с длинными текстами и улучшило контекстное обучение. В среднем понимание взаимосвязей в тексте в новой архитектуре стало лучше на 10%.

По данным T-Bank AI Research, архитектура ReBased способна снизить издержки на использование ИИ для специализированных задач, которые имеют конкретную область применения и требуют учета ее особенностей. Например, в медицине это классификация текстов на основе симптомов и диагнозов.

Предложенная T-Bank AI Research новая архитектура позволяет приблизить качество линейных моделей к трансформерам. Модели, в основе которых лежит ReBased, могут генерировать тексты с более низкими требованиями к ресурсам практически без потери качества. В перспективе, считают исследователи, линейные модели все чаще будут использоваться в комбинации с трансформерами в качестве составной части гибридных архитектур. Такие архитектуры сочетают в себе и скорость, и высокое качество выполнения задач.

Исходный код проекта T-Bank AI Research и дополнительные материалы по этой теме опубликованы на GitHub.