Новейшие проекты компании ориентированы прежде всего на ускорение, оптимизацию и широкое внедрение генеративного ИИ. В их числе – графические процессоры Blackwell, спроектированный Nvidia сервер для организации ИИ-вычислений с 16 «суперчипами» GB200 Grace Blackwell и набор генеративных ИИ-моделей для платформы Nvidia AI Enterprise.

Компания Nvidia, ведущий на сегодня в глобальном масштабе разработчик аппаратно-программных платформ для тренировки и исполнения моделей генеративного ИИ, в ходе масштабного мероприятия GTC 2024 обнародовала информацию о более чем десятке своих новейших проектов. Которые, если удастся воплотить их в жизнь как задумано, наверняка приведут к дальнейшему росту капитализации этой компании – от нынешних и без того немалых 2,2 трлн долл.

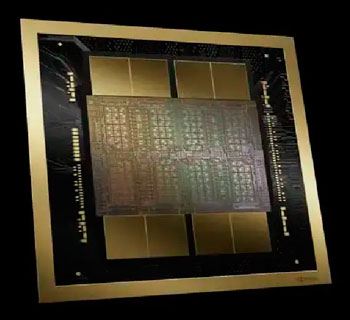

Пожалуй, наиболее ожидаемой и обсуждаемой новинкой, представленной на мероприятии, стала архитектура графических процессоров Blackwell, дополнительно оптимизированная для обработки задач, имеющих отношение к ИИ.

Серверные графические ускорители B100 и B200 на базе Blackwell, с ориентировочной оптовой ценой в пределах 30–40 тыс. долл. за единицу, станут наследниками применяемых сейчас в подавляющем большинстве ИИ-ориентированных дата-центров мира картам H100 на основе чипов Nvidia Hopper.

Компания-разработчик утверждает, что в ходе исполнения типичных для генеративного ИИ задач создания контента на основе задаваемых оператором вводных чипы Blackwell покажут существенно более высокую производительность (вплоть до 30-кратного превосходства) при значительно меньшем энергопотреблении (да 25 раз) по сравнению со своими предшественниками поколения Hopper. Кроме того, заказчикам предложат «суперчип» GB200 Grace Blackwell, содержащий в единой упаковке два графических процессора B200 плюс базирующийся на ARM-архитектуре 72-ядерный центральный процессор Nvidia Grace.

Оптимальным же готовым продуктом для организации ИИ-вычислений – в особенности для сложных моделей и с многопользовательским облачным доступом – компания считает спроектированный ею сервер, включающий 16 «суперчипов» GB200 Grace Blackwell с жидкостным охлаждением. Именно такой сервер в виде инженерного прототипа и продемонстрировал, по заверению Nvidia, 30-кратное превосходство при исполнении генеративных моделей ИИ в сравнении с типичным на сегодня для облачных инсталляций сервером с 64 процессорами H100.

Кроме того, на GTC 2024 были представлены серверные системы с воздушным охлаждением DGX B200 (на 8 ГП B200 и два ЦП архитектуры x86), вычислительный кластер DGX SuperPod (288 ЦП Grace, 576 ГП B200 и 240 Тбайт видеопамяти, общая производительность до 11,5 ЭФЛОПС), высокоскоростные сетевые платформы для межсоединений ИИ-серверов Quantum-X800 InfiniBand и Spectrum-X800 с производительностью до 800 Гбайт/с, целый набор генеративных ИИ-моделей в статусе «микросервисов» для фирменной корпоративной программной платформы Nvidia AI Enterprise – и много других программных и аппаратных новинок, ориентированных прежде всего на ускорение, оптимизацию и как можно более широкое внедрение генеративного ИИ.