В Москве прошла конференция «SMARTDEV 2023». В рамках секции “ML / AI” (машинное обучение / искусственный интеллект) была проведена панельная дискуссия “Революция больших языковых моделей: перспективы и направления развития.”

21 сентября в Москве прошла конференция «SMARTDEV 2023». В рамках секции “ML / AI” (машинное обучение / искусственный интеллект) была проведена панельная дискуссия “Революция больших языковых моделей: перспективы и направления развития.”

В ее рамках были обозначены базовые проблемы, характерные для современных LLM. Намечены возможные пути их решения, возможные направления развития и перспективы.

В дискуссии приняли участие:

СЕРГЕЙ МАРКОВ SberDevices — Модератор дискуссии

ДМИТРИЙ СОШНИКОВ — НИУ ВШЭ

МИХАИЛ БУРЦЕВ — London Institute for Mathematical Sciences

ВАН ОСЕЛЕДЕЦ — AIRI / Сколтех

МАКСИМ ЕРЕМЕНКО — Сбер (Sber AI)

АЛЕКСАНДР КРАЙНОВ — Яндекс (Yandex)

Для начала, напомним общий контекст происходящего в сфере NLP (обработки текстов на естественных языках).

В 2017 году была предложена архитектура Transformers, использующая базовый подход кодировщика/декодировщика для генерации контента по входному промпту. Эта архитектура использует слои Attentions (внимания) для автоопределения “важности” токенов во входном запросе. Это позволяет модели сконцентрироваться на определенных участках фразы, и определить связи между частями предложения в рамках текущего контекста.

В результате обученная нейросеть с миллиардами параметров подбирает наиболее вероятные ответы на запросы пользователя. При этом, следует понимать, что такая модель не способна достаточно абстрагироваться для построения общих правил предметной области на уровне понятий (генерализации); по сути, она просто генерирует ответ, обобщая последовательности токенов из датасета на котором происходило обучение.

На этой архитектуре строится большинство современных LLM, включая наиболее распространенное на сегодня семейство GPT. Такие решения способны переводить на другие языки, выдавать программный код, составлять аннотации текстов, делать пересказы, отвечать на вопросы, генерировать тексты сложной структуры или в обозначенной стилистике, формулировать перечни идей, готовить промпты к другим моделям, например диффузионным генераторам изображений и т. д.

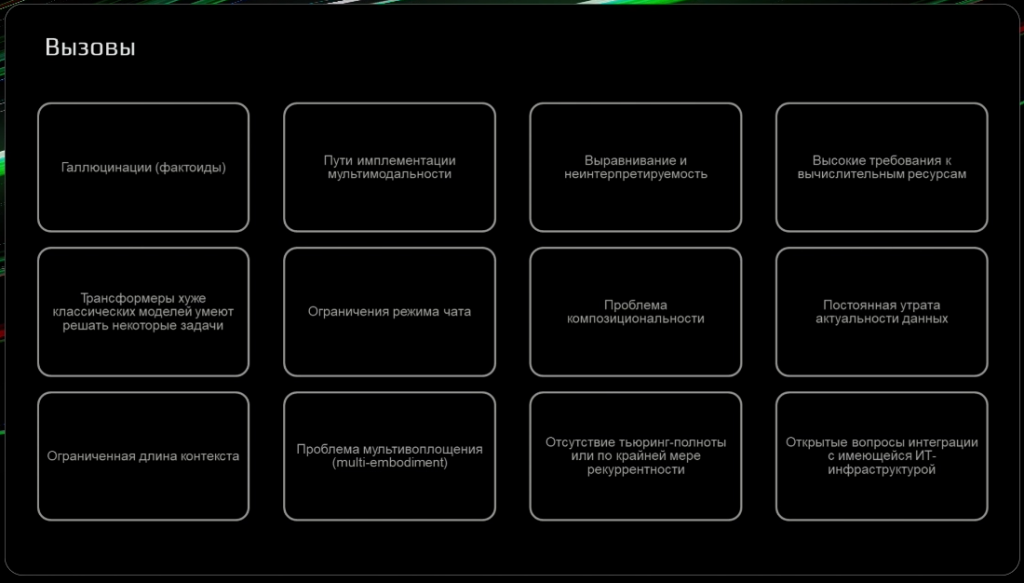

“Какие вызовы сейчас стоят пред языковыми моделями?”

Для понимания сути панельной дискуссии, неплохо бы обозначить те общие недостатки, которые остаются актуальными для трансформерных систем и сервисов на их основе. Их достаточно емко обозначит в своем, уже последующем докладе о Sber GigaChat, ведущий дискуссии С. Марков.

- Фактоиды (галлюцинации) — Модели выдумывают несуществующие факты, дают неверные определения. Это связано с тем, что алгоритм вынужден дать хоть какой-нибудь ответ, даже если pretrained модель ответа не знает. Так генерируются более-менее “похожие на правду”, но искаженные по смыслу ответы.

- Имплементация мультимодальности. Современные ИИ-сервисы стремятся обеспечить мультимодальность — соединить несколько моделей разных типов в одном решении. Например, обрабатывать и выдавать не только текстовые данные, но и генерировать изображения, звук, обрабатывать программный код, табличные данные и проч. Интеграция различных кодеров/декодеров в один сервис — нетривиальная задача для разработчиков.

- Выравнивание и неинтерпретируемость. Под выравниванием в данном случае понимается способность модели верно интерпретировать промпт — выдавать то, что от нее хочет пользователь не только по форме, но и по содержанию.

- Трансформерные модели, зачастую хуже классических умеют решать некоторые задачи. Например, известно, что они практически не могут выполнять арифметические вычисления, лишь запомнить, что “дважды два будет четыре”.

- Проблема композициональности. Некоторые индуктивные зависимости между упоминаемыми сущностями, существующие в языке — очевидные человеку, трансформеру трудно вывести. Моменты генерализации, правил — вообще с трудом обучаемы посредством алгоритма Feed Forward, используемого в блоках Attentions.

- Проблема актуальности данных. Предобученная модель в любом случае обучена на корпусе текстов, опубликованных до известной даты. А новая информация поступает постоянно. Дообучение — дорогостоящий процесс; обновлять LLM-модель регулярно крайне трудоемко.

- Ограниченная длина контекста. Сам механизм MultiHead Attention имеет низкую рекурентность — “физические” ограничения по объему сохраняемого внутренними слоями окна данных. Невозможно учитывать контекст при обработке большого текста или длинной чат-сессии вопрос-ответ . Система начинает “забывать” контекст обработанный ранее, если общий объем входа достаточно велик.

- Отсутствие Тьюринг-полноты и ограниченная рекурентности. Отсутствие у предобученной модели возможности имитировать любой вычислительный процесс или алгоритм. Рекурентность — это свойство, которое позволяет сети использовать информацию, полученную на предыдущих шагах, для принятия решений на текущем шаге. Такая возможность, с известными ограничениями, имелась у предшественников Attentions — RNN типа LSTM или GRU, но в классических трансформерах с этим возникают трудности.

- Высокие требования к вычислительным ресурсам.

- Ограничения режима чата. Интеллектуальные задачи не всегда удобно решать из-за ограничений GUI конкретного чат-бота, скажем, интерфейса Telegram.

- Multi Embodiment — проблемы воплощения. Желание связать вход и выход модели с различными интеллектуальными агентами, возможность работать на разных платформах и в разных прикладных окружениях.

- Открытые вопросы интеграции с унаследованной ИТ-инфраструктурой.

Решение вышеназванных проблем, на базе ли трансформеров или с применением иных подходов, откроет перспективы для дальнейшего развития отрасли.

Как отметил Михаил Бурцев, основной проблемой современных моделей является то, что они “знают много о разном, но с точки зрения моделирования рассуждения их возможности очень сильно ограничены”. Это снижает применимость этих моделей: “Нельзя, например, с помощью больших языковых моделей хорошо что-то планировать.” За исключением рецептов разрешения каких-то совсем уж шаблонных ситуаций.

“Ни один из многочисленных экспериментов, не показал что эти модели хорошо генерелизуют, и могут действовать в соответствии с некими правилами.”

— Михаил Бурцев, London Institute for Mathematical Sciences.

Здесь возникает проблематика эмерджентности. Emergent behavior — это когда система проявляет свойства, которые не были явно запрограммированы в ее компонентах. Применительно к LLM, это может проявляться в способности модели возвращать разумный и связный текст даже по вопросам, которые явно не упоминались ни в учебном датасете, не в контексте сессии инференса. Однако, эту проблему, судя по всему нельзя решить просто за счет наращивания размерности модели. Скорее всего, на текущих архитектурах она неразрешима в общем виде.

Впрочем, проблемы с качеством выдачи сети, возникающие из-за плохой генерализации, композициональности и рекурентности могут быть локально решены несколько иным образом. За счет интеграции многих моделей или сервисов.

“Мне кажется, будущий правильный путь — это переброска запросов в сложном ансамбле специализированных сетей, где каждый элемент ансамбля решает свою узкую задачу.” — предлагает Александр Крайнов из “Яндекс”. — “Или, для определенных задач, и не нейростей вовсе, а других алгоритмов, потому что когда мы говорим, допустим, про математический аппарат — нейронки не самый эффективный метод.” Это позволит лучше решать ряд конкретных задач.

Однако, конечно, это не отменяет того факта, что наши модели по сути — “это просто статистика слов, пусть и на максималках. Это — не рассуждение. … И текущие модели нас не приблизили к решению этой проблемы.” — подводит итог Александр Крайнов из «Яндекс».

Кстати, бытующее в массах фундаментальное непонимание чем же по сути в текущей реализации является то, что именуется высоким словом “искусственный интеллект”, — является одной из проблем их распространения и внедрения в реальные бизнес-процессы. Не понимая, что нейросети не способны вырабатывать суждения, а лишь подбирают наиболее вероятный ответ, пользователи могут испытать фрустрацию.

“Если мы сегодня спросим на улице людей, используют ли они большие языковые модели, мы узнаем, что лишь 5-10% ответят да, еще 30% скажут, что что-то об этом слышали. Это дает большой потенциал для увеличения пользовательской базы.” — говорит Дмитрий Сошников из НИУ ВШЭ. — “Но люди, часто сталкиваются здесь с обманутыми ожиданиями, надеясь что ИИ ответит на любые вопросы, вплоть до пресловутого «о смысле жизни”. Но оказывается, что так это не работает. Оказывается, чтобы решить задачу нужно постараться.”

Промпт-инжениринг — неотъемлимая часть взаимодействия с подобными системами.

“Считаю, что нужно больше объяснять людям, что ИИ — это не какой-то мудрый разум, способный на все. А это некий инструмент, который нужно научиться использовать.” — заключает Дмитрий Сошников из НИУ ВШЭ.

В целом, на современном этапе использование больших моделей — это совместная деятельность человека и машины. Оператор, промпт-инженер задает контекст и поэтапно “подводит” машину к результирующей выдаче.