Представленный стартапом SambaNova нейрочип SN40L способен достигать производительности в 638 TFLOPS, а сборка из восьми SN40L – обеспечивать работу с ИИ-моделями, содержащими до 5 трлн параметров.

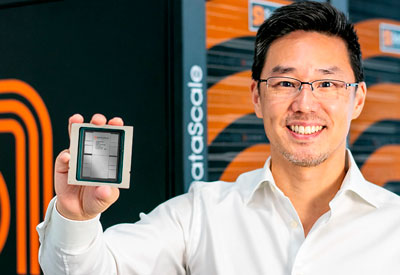

Стартап-«единорог» SambaNova из калифорнийского Пало Альто, известного как место «прописки» таких ИТ-гигантов, как Hewlett-Packard и VMware, представил недавно новейший нейрочип SN40L – способный, по заверениям разработчиков, революционизировать направление тренировки моделей искусственного интеллекта. Именно тренировка требует значительных аппаратных ресурсов (множества серверных графических адаптеров с десятками гигабайт видеопамяти на каждом) и продолжительного времени, что в значительной мере ограничивает развитие конкурирующих с ChatGPT генеративных языковых моделей.

Спроектированный специалистами SambaNova процессор SN40L уже изготавливается по 5-нм технологии на мощностях тайваньского чипмейкера TSMC. Микросхема состоит из 102 млрд транзисторов, формирующих 1040 вычислительных ядер, и содержит три уровня оперативной памяти (520 Мбайт интегрированной, 1,5 Тбайт внешней и еще 64 Гбайт дополнительной, представленной микросхемами HBM), для соединения которой с ядрами применена не фиксированная шина определенной ширины, а высокоскоростная реконфигурируемая среда (high-speed switching fabric). Это позволяет единичному чипу достигать производительности в 638 TFLOPS, а сборке из восьми SN40L – обеспечивать работу с ИИ-моделями, содержащими до 5 трлн параметров.

Потенциал цифровой многослойной нейросети, к которой по сути сводится генеративный ИИ, определяется числом и точными значениями параметров на входах каждого из образующих ее слои искусственных нейронов. Чем больше этих нейронов (и соответственно чем выше число параметров, задающих проводимые нейронами операции взвешенного суммирования поступающих сигналов), тем более сложные задачи оказывается способна решать нейросеть. Модель GPT-4, лежащая в основе популярного бота ChatGPT, сформирована 120 слоями и включает 1,8 трлн параметров. Таким образом, если сопоставлять используемое ныне для обучения и запуска ChatGPT «железо» с возможностями SN40L, оказывается, что суммарная стоимость владения необходимым для таких задач оборудованием в случае разработки SambaNova оказывается в 25 раз ниже, чем для стандартного ИИ-сервера со множеством «тяжелых» графических адаптеров.

Правда, имеется немаловажный нюанс: классический сервер с несколькими видеокартами, построенный на базе архитектуры х86, представляет собой универсальную систему, способную – пусть далеко не оптимально в плане нагрузки на аппаратную часть – тренировать и исполнять любую ИИ-модель. Разработка же SambaNova при всей ее экономичности базируется на ином подходе: вместо последовательной обработки инструкций, к чему сводится исполнение любой программы на х86-системе, фирменное ПО процессора SN40L анализирует исполняемую модель машинного обучения – и, по сути, динамически переконфигурирует связи (каналы передачи данных) между вычислительными ядрами и ячейками памяти во всех трех доступных слоях так, чтобы наилучшим образом воспроизводить на аппаратном уровне программную логику функционирования данной конкретной модели.

За счет такого подхода как раз и обеспечивается оптимальное использование доступных ресурсов. В то же время далеко не всякая генеративная ИИ-модель поддается оптимизации указанным способом – что лишает SN40L присущей классическим ИИ-серверам универсальности. По этой причине SambaNova продает заказчикам не свои чипы, а услугу доступа к ним (точнее, к исполняемым на них предварительно оптимизированным и натренированным моделям) через облако. Что, собственно, в немалой степени снижает коммерческий потенциал новой разработки: создавать независимую ИИ-модель, исходно ориентированную на проприетарный чип с закрытой архитектурой, потенциальным заказчикам будет значительно сложнее и дороже, чем пригодную для запуска на любом х86-сервере с подходящими характеристиками, да и передавать для тренировки модели чувствительные бизнес-данные на сторону далеко не все готовы.

Однако не исключено, что удачные находки (особенно в плане реконфигурируемой среды соединения вычислительных ядер с многоуровневой памятью) SambaNova окажутся востребованными в ходе разработки уже следующих поколений серверных графических адаптеров для архитектуры х86. В этом случае очередная серия генеративных ИИ-моделей – в особенности мультимодальных, с равным успехом готовых работать с текстом, изображениями, звуками, видео – имеет все шансы сделаться менее ресурсоемкой и оттого еще более востребованной, чем нынешние версии.