Поскольку использование облачных ИИ менее безопасно и удобно, чем локально установленных, производители смартфонов активно работают над интеграцией соответствующей функциональности в перспективные модели своих гаджетов, по крайней мере в те, «железо» которых отвечает требованиям генеративных ИИ-моделей.

Получить сегодня доступ к умному чат-боту с мобильного телефона достаточно просто – популярные большие языковые модели искусственного интеллекта широко доступны, в том числе даже не требующие авторизации на сайте для начала беседы. Однако иметь дело с развернутым в облаке ИИ – это одно, а с локально установленным – совсем другое. Недаром Конгресс США недавно напрямую запретил своим сотрудникам использовать умный помощник Microsoft Copilot, прежде всего из соображений безопасности: какими бы добрыми ни были намерения разработчиков умных чат-ботов, передавать облачному ИИ для обработки чувствительные данные, тем более имеющие отношение к делам государства, не лучшая идея.

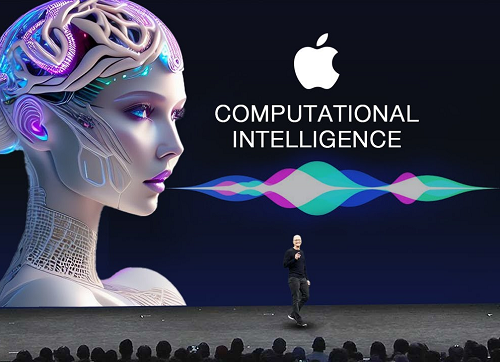

Осознавая растущую осведомленность пользователей об опасностях и неудобствах облачных ИИ, смартфонные вендоры активно работают над интеграцией соответствующей функциональности в перспективные модели своих гаджетов – по крайней мере, в наиболее производительные, «железо» которых отвечает довольно высоким требованиям генеративных ИИ-моделей. Вот и исследователи из Apple опубликовали научную работу, которая, как можно предположить, ляжет в основу грядущего расширения функциональности голосового помощника Siri.

Усиленный генеративным ИИ помощник сможет вести контекстно зависимый диалог с пользователем, принимая в расчет не только формулируемые голосом запросы, но и актуальное состояние смартфона в руках человека: что в настоящий момент отображается на экране, какие приложения запущены, какие сайты перед этим посещал пользователь и т. п. Исследователи из Apple отмечают, что уже в нынешнем своем виде, пока далеком от готовности к широкому внедрению, их генеративная модель – даже в самой компактной версии, оптимизированной для запуска на смартфоне, – обрабатывает контекстно зависимые запросы лучше, чем популярные чат-боты на основе GPT-3.5 и GPT-4, исполняемые в облаке. Ради чистоты эксперимента последним в ходе состязательного испытания предоставлялась та же дополнительная информация, которой руководствовалась модель Apple: скриншоты экранов смартфонов, данные о запущенных на момент запроса приложениях и т. п.

Более того, исследователи заявляют, что их разработка под названием ReALM (Reference Resolution As Language Modeling) в наиболее полной своей версии уже превосходит GPT-4 – по сути стандарт де-факто для современных мультимодальных (готовых к восприятию не только текстовых, но и звуковых, и изобразительных входных потоков данных) больших языковых моделей. И хотя статья в популярном издании 9to5Mac, описывающая эту работу, появилась 1 апреля, исходная работа коллектива из Apple датирована 29 марта. Так что вряд ли у компании теперь выйдет обратить все в шутку, если следующее поколение iPhone поступит в продажу без доведенной до ума версии ReALM, которую поклонники Siri наверняка воспримут самым положительным образом.